今回はローカル環境で大規模言語モデルを手軽に利用できるGUIツール「LM Studio」をご紹介します。

目次

はじめに

近年の生成AIの発展により、日常におけるAIモデルの利用が一般化してきています。AIモデルの実用性や利便性が認知されてきたことで、ビジネスやプライベートでの活用の場が増えており、益々AI関連のコミュニティも活発になってきました。

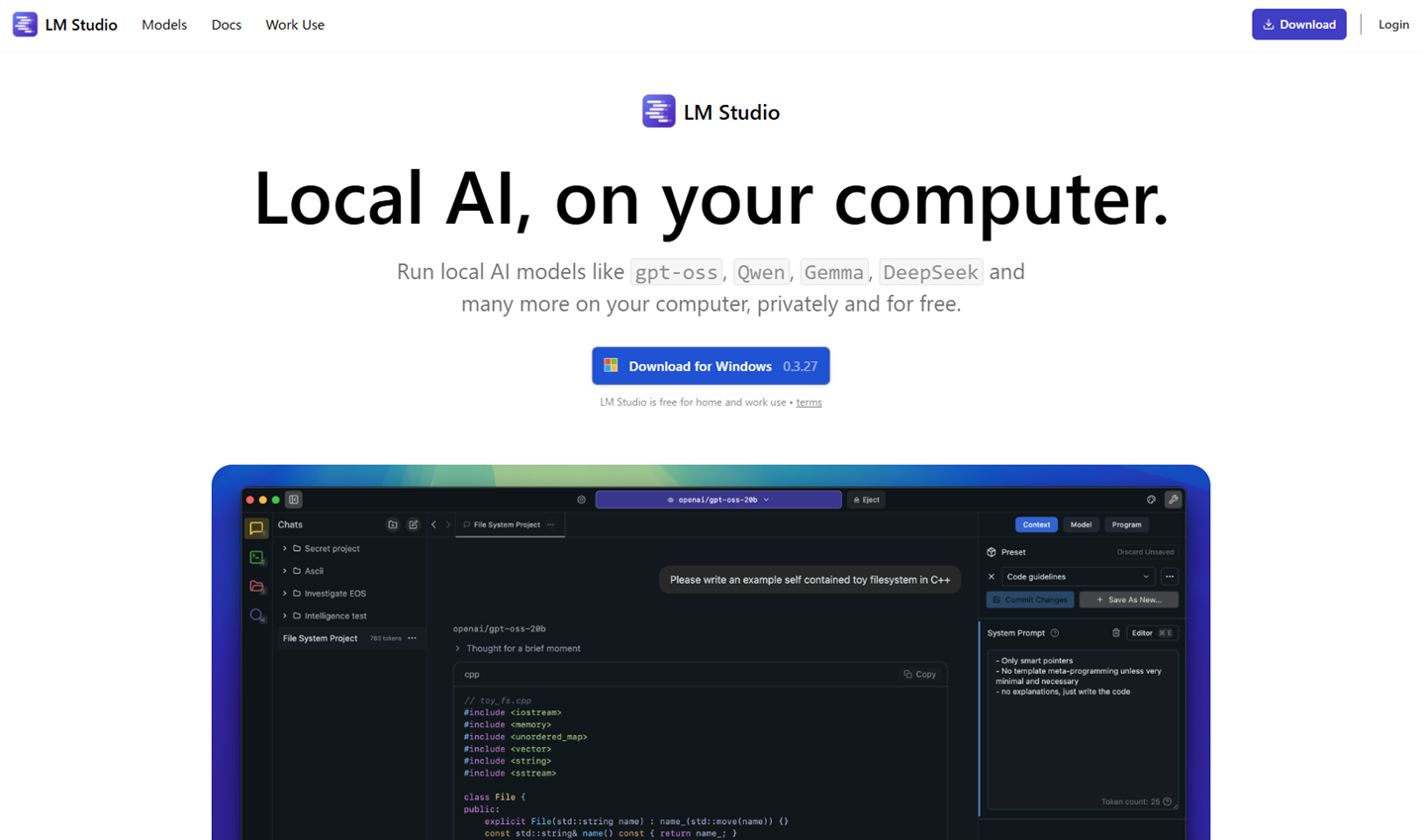

今回は、ローカル環境で大規模言語モデルを手軽に利用できるツールであるLM Studioを紹介していきます。LM Studioの特長と使い方を解説していますので、AIモデル活用の参考にしてみてください。

LM Studioとは

LM Studioは、大規模言語モデル(以下、LLM)をローカル環境でGUI操作できるデスクトップアプリケーションです。

Windows/macOS/Linuxに対応しており、テキストチャットによる対話、文章の要約、アイデア出し、調べものなどに活用できます。テキストのプロンプト以外にもpdfやdocx、txtなどのファイル形式に対応しており、長い文章でも読み込めます。

使用するLLMは、AIモデル公開プラットフォームのHugging Faceからダウンロードして利用できるほか、GGUF形式などローカルに保存したモデルファイルを直接読み込むことも可能です。用途に合わせてモデルを切り替えられ、LM Studio上でAPIサーバーを立ち上げて他アプリケーションから接続することもできます。

初回のモデルダウンロードにはインターネット接続が必要ですが、その後は完全オフラインで実行できるため、機密情報を守りながらAIモデルを活用できます。利用は基本的に無料で、商用サポートや追加機能を含む有料プランも用意されています。

LM Studioの特長

オフライン実行で機密データを保護できる

LM StudioはHugging Faceやローカルのモデルをダウンロードして使用するため、クラウド型AIサービスのように入力データが外部サーバーへ送信されません。初回ダウンロード後はオフライン利用が可能で、入力内容が学習データとして再利用されることもないため、社内の機密情報やプライベートなデータを扱う場合に適しています。

長文や外部データも取り込み可能

チャットによるテキスト入力だけでなく、PDFやテキストファイルなどの長文ドキュメントを読み込み、質問応答を行うことができます。これは検索拡張生成(RAG)と呼ばれる仕組みにより、モデルの知識を疑似的に拡張して回答を生成するものです。学習をやり直してコストをかけなくても、最新情報や社内資料をモデルに参照させることが可能です。

GUIでわかりやすいツール

LM StudioはAIモデルの導入や利用を簡単にしてくれます。本来、Hugging FaceからダウンロードしたLLMを利用するには、コマンドによるインストール作業やプログラミング言語を用いた操作が必要になります。LM Studioではその導入作業がバックグランドで行われ、利用者はすぐに生成AIの利用を始められます。また、GUI上でのテキスト入力やファイルのドラッグランドドロップなど直感的な操作で生成AIの能力を体験できます。

コストを抑えながら使える

クラウド型のLLMサービスでは、リクエストごとにトークン課金や月額課金が発生します。一方LM Studioでは、モデルを一度ダウンロードすれば利用回数や文字数に応じた追加料金は不要です。初期導入にはGPU搭載PCや十分なストレージが必要ですが、ランニングコストはPCの電気代とハードウェア維持費程度で、社内の複数ユーザーが同じ環境を利用してもユーザー単位の課金が発生しないため、長期的には大幅なコスト削減が可能です。

LM Studioを使ってみよう

ここからはLM Studioの使い方を紹介していきます。LM Studioを始めるには、まずアプリケーションのインストールが必要です。

LM Studioのインストール

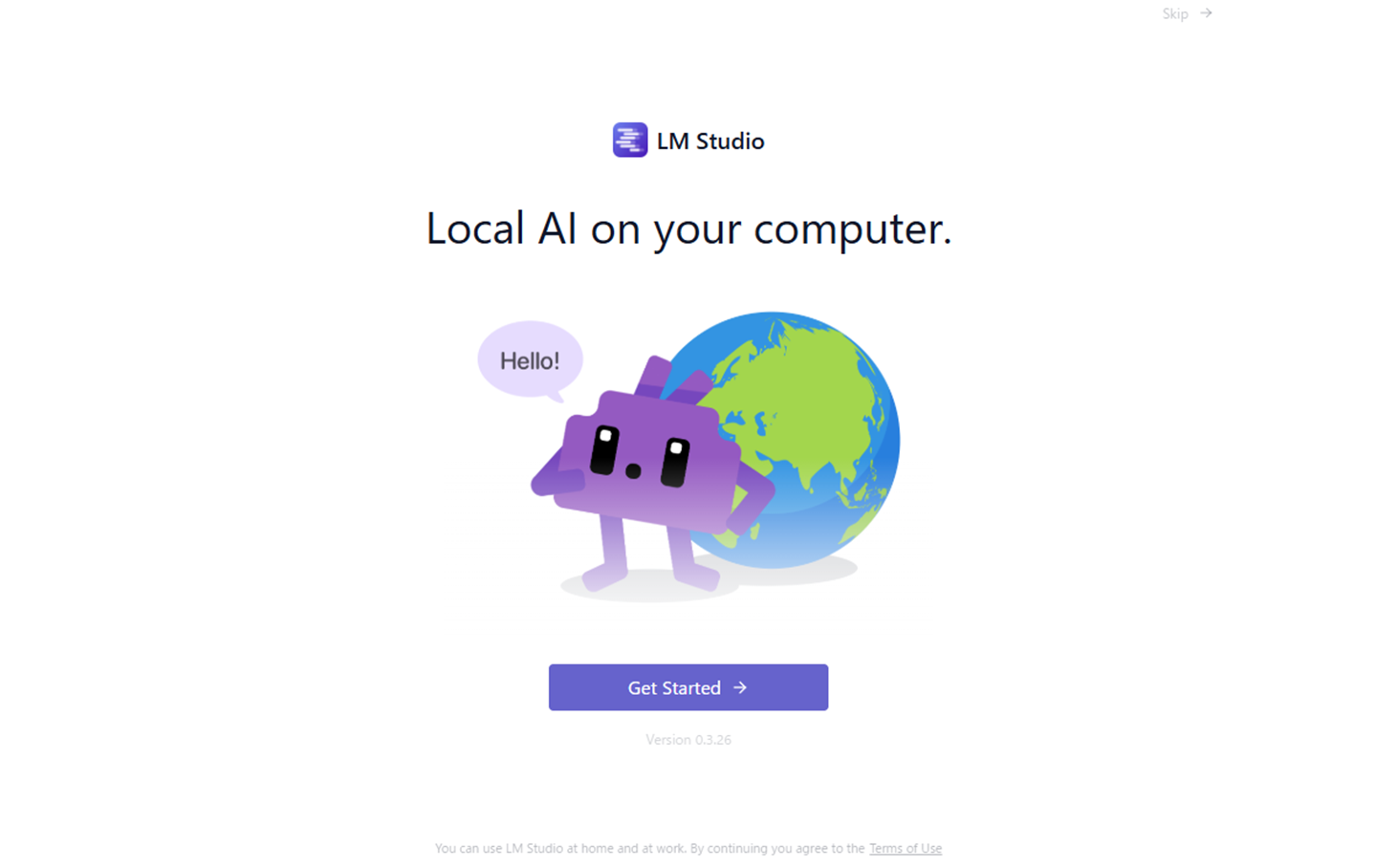

まずはLM Studioの公式サイトからインストーラーをダウンロードしましょう。

インストーラーを起動すると下記の画面が表示されますので、[Get Started]を押下します。

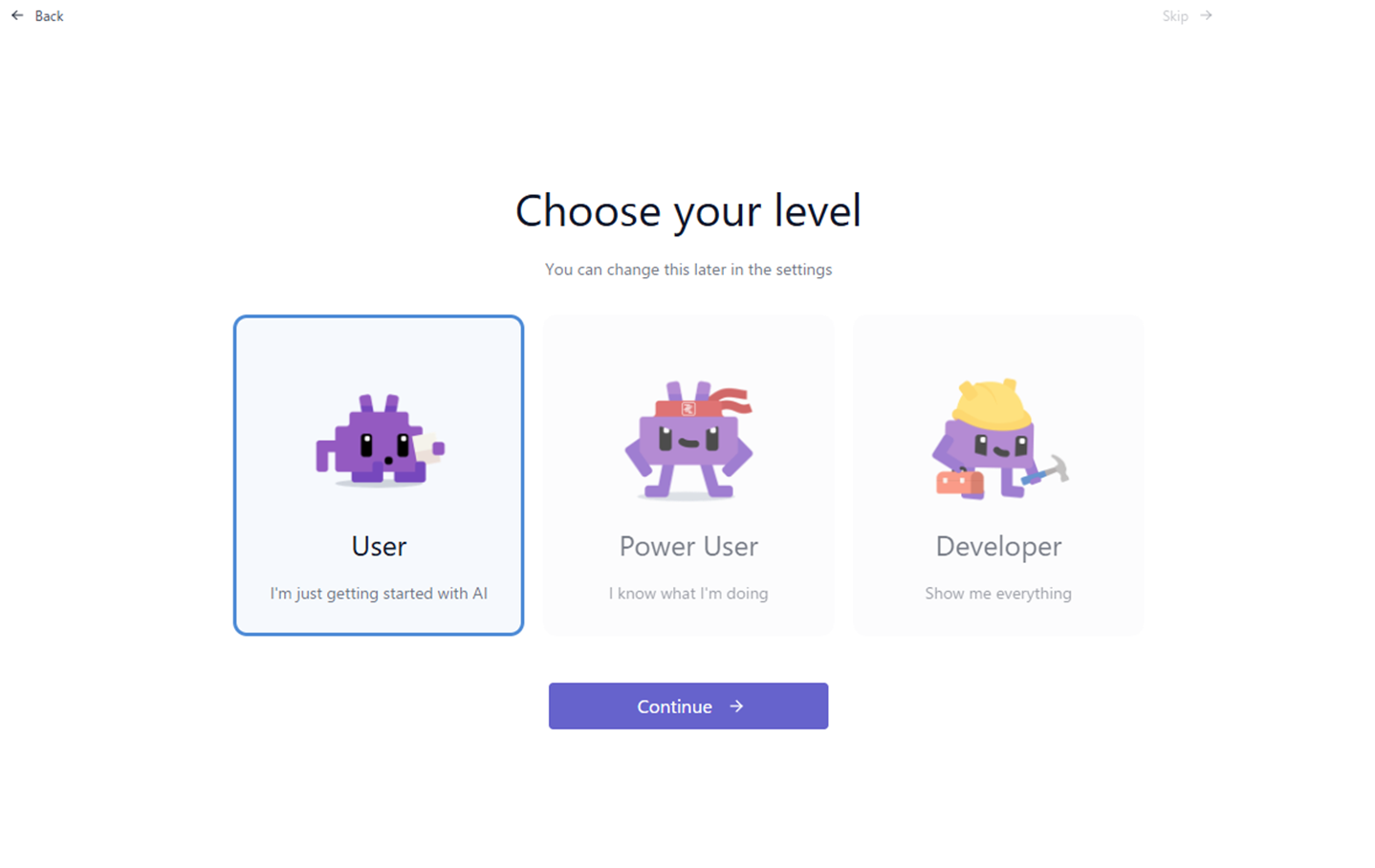

次に、利用者の属性を選択します。ここでは「User」を選択し、[Continue]を押下して次に進みましょう。

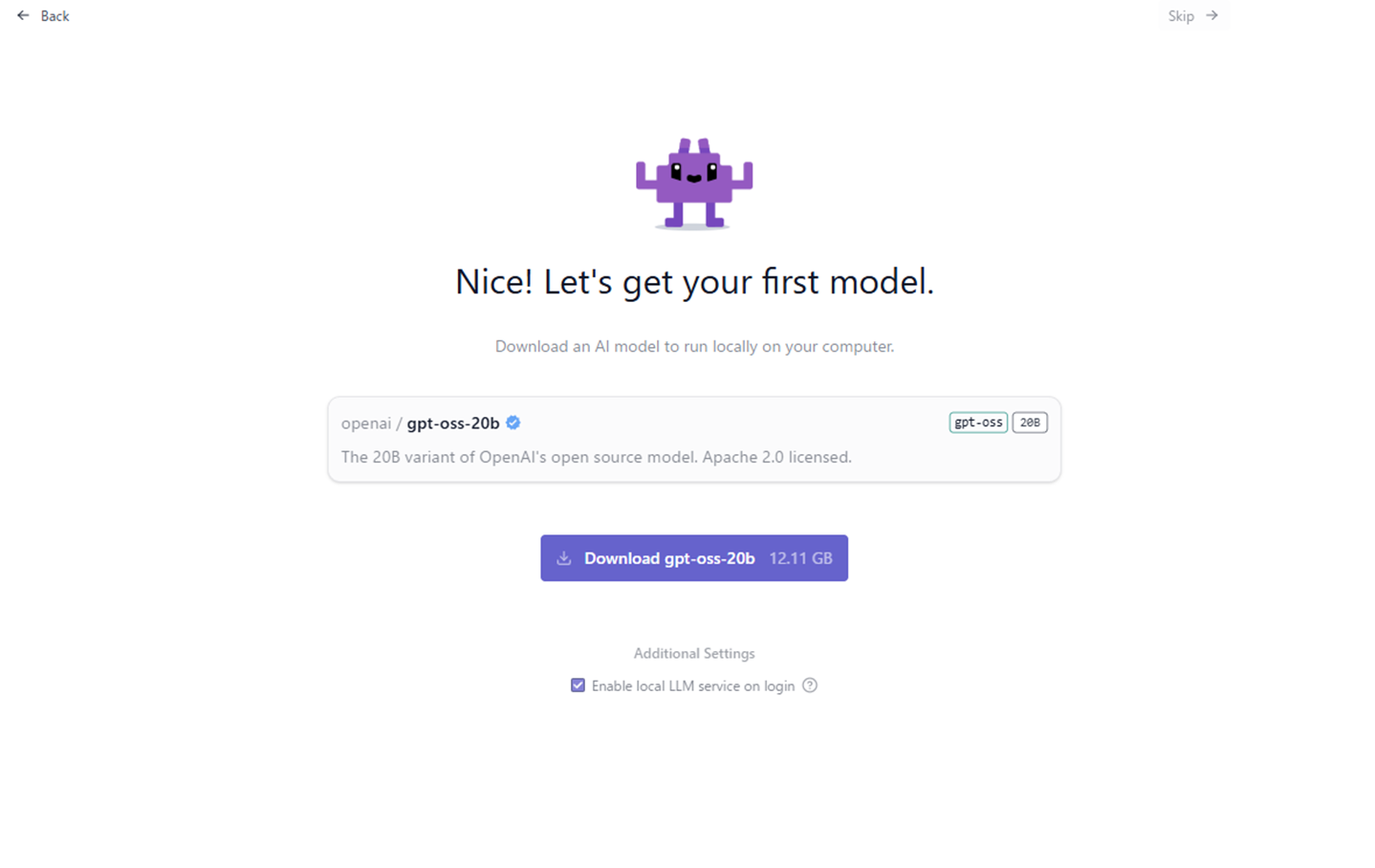

続いて、LLMのダウンロードを促す画面が表示されるので、[Download gpt-oss-20b]を押下して、「gpt-oss-20b」をダウンロードします。2025年9月時点では「gpt-oss-20b」は12GB以上のファイルサイズなので、ローカルディスクの空き容量に注意しましょう。

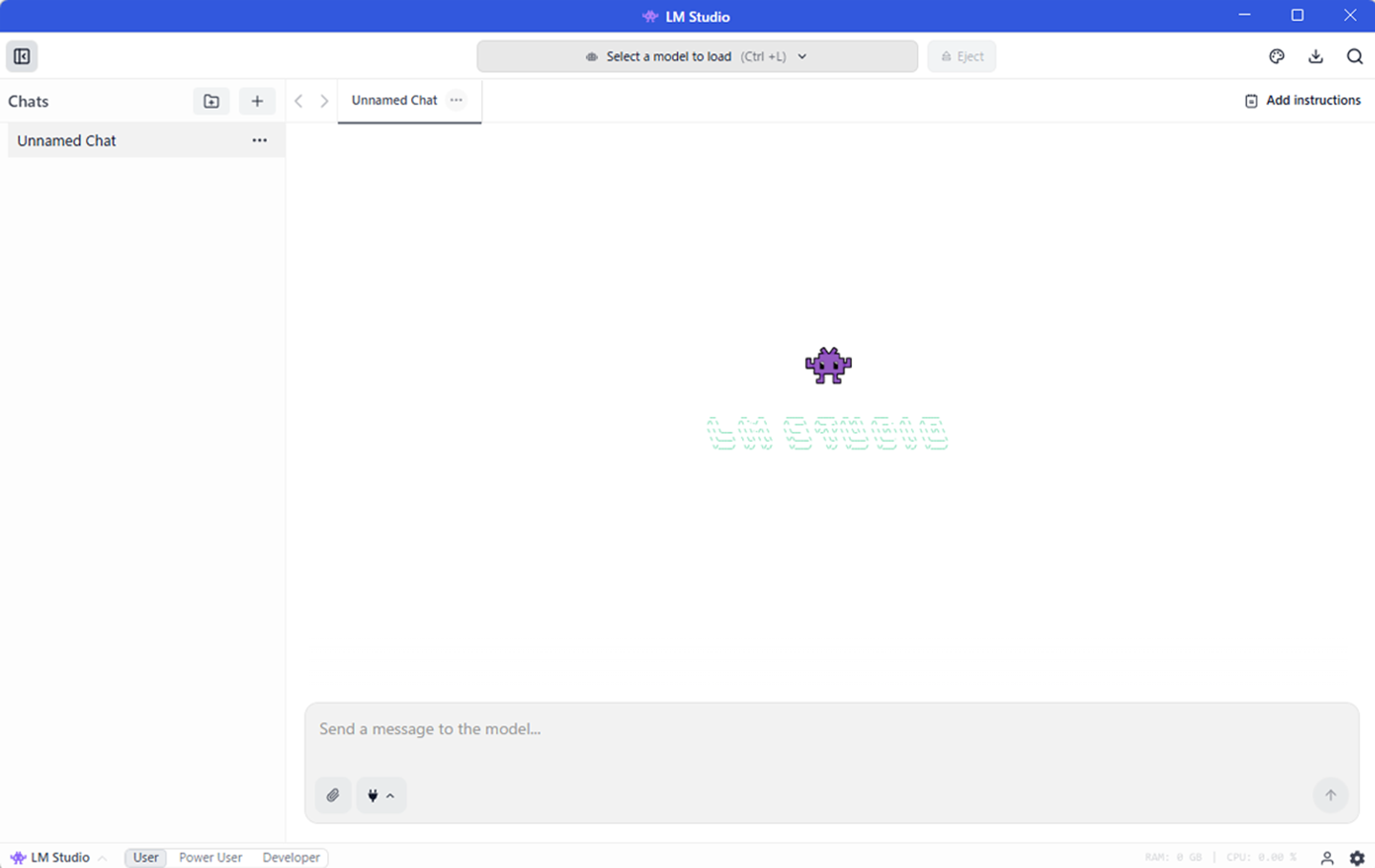

完了したら[Start a New Chat]を押下してアプリケーションを起動しましょう。起動すると下記のような画面が表示されます。

LM Studioでプロンプトを入力

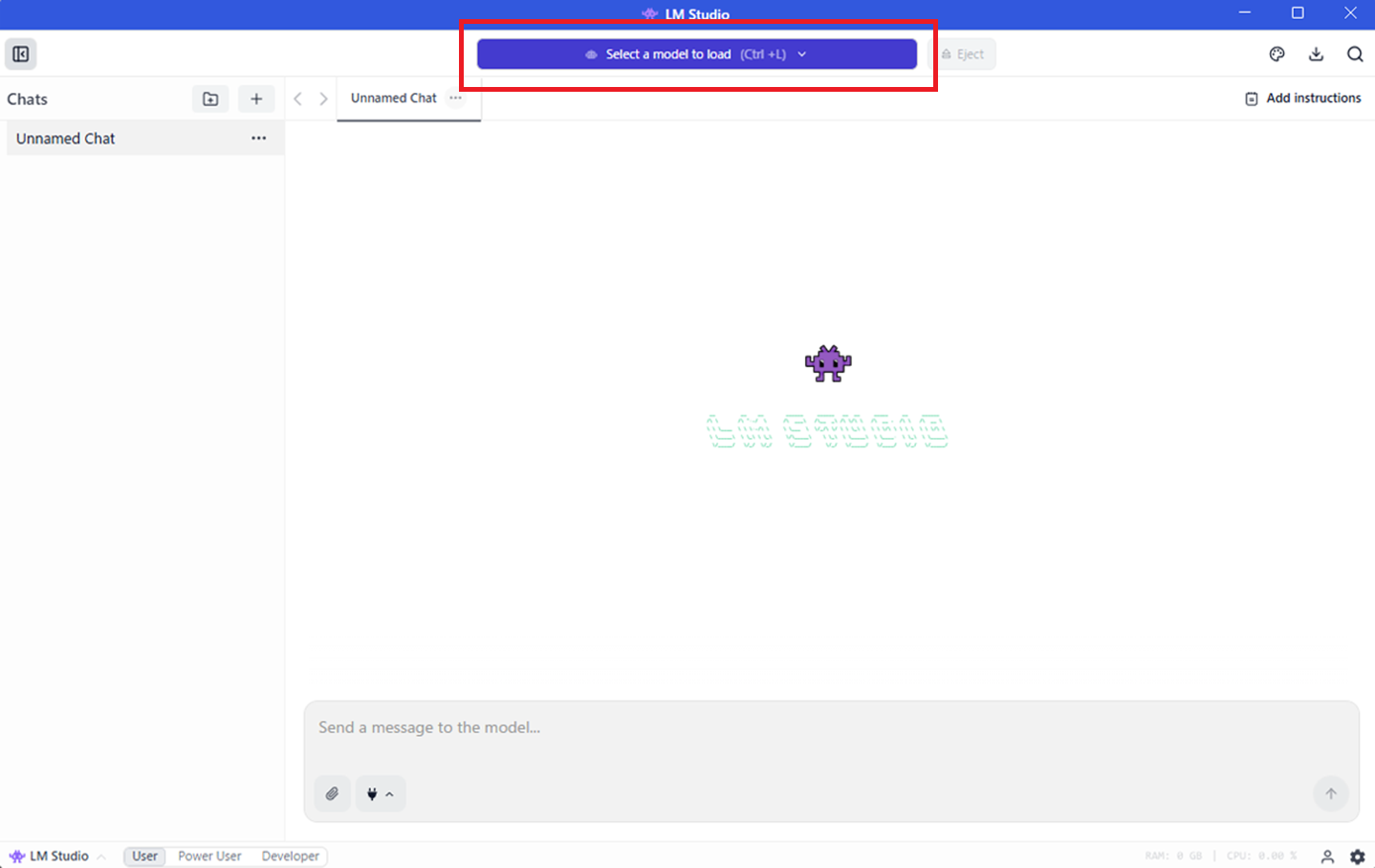

LM Studioを開き、[Select a model to load]を押下しましょう。

使用するAIモデルの候補が表示されるので、前節でダウンロードしたAIモデルを選びましょう。

AIモデルを選択したら、下部のテキストエリアにプロンプトを入力してみましょう。下記はAIモデルのgpt-ossについて尋ねた結果です。

このように、LM Studioを使うと公開されたAIモデルを簡単な操作で試すことができます。

LM StudioのローカルLLMをClineから呼び出す

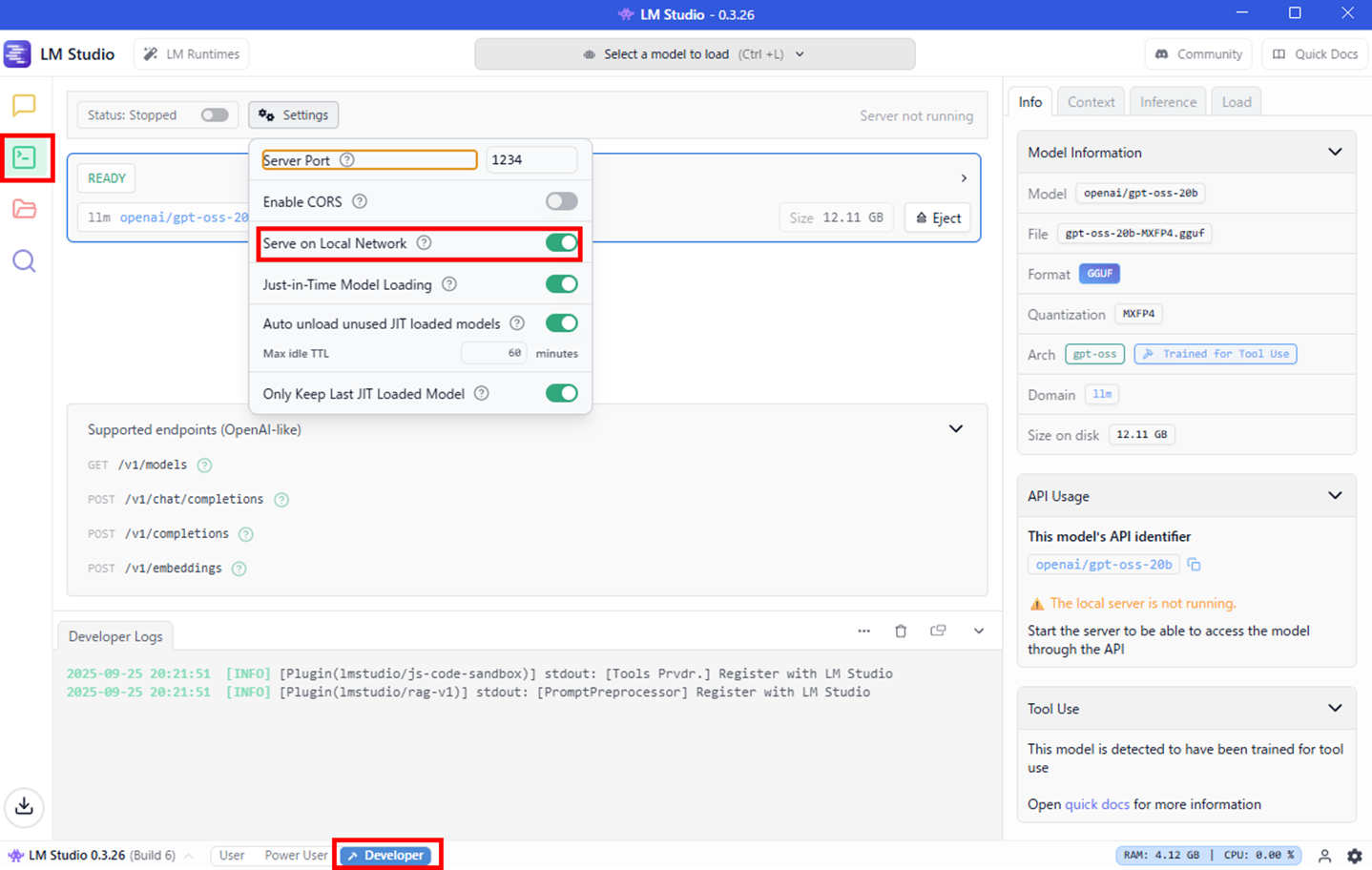

まずはAPIサーバーを起動するためにLM Studioで設定を行いましょう。LM Studioの画面下部にある「Developer」のタブを押下します。

続けて左側のサイドメニューにある上から2番目のボタンを押下し、[Settings]を押下しましょう。ウィンドウが表示されたら「Serve on Local Network」をオンにします。

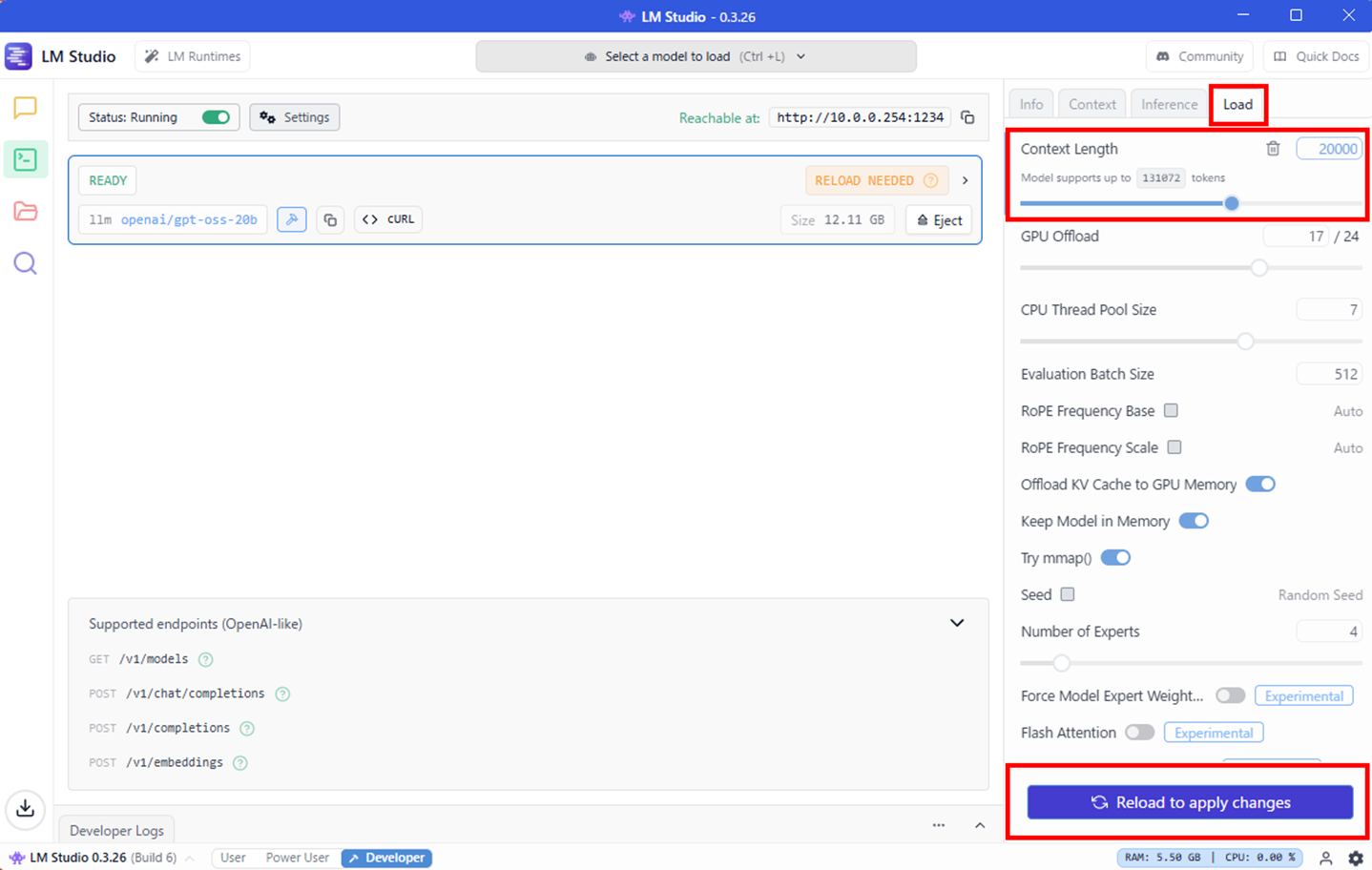

また、右側のパネルから「Load」のタブを押下し、「Context Length」を「20000」に変更しましょう。変更できたら、下部のボタン[Reload to apply changes]で設定を保存します。

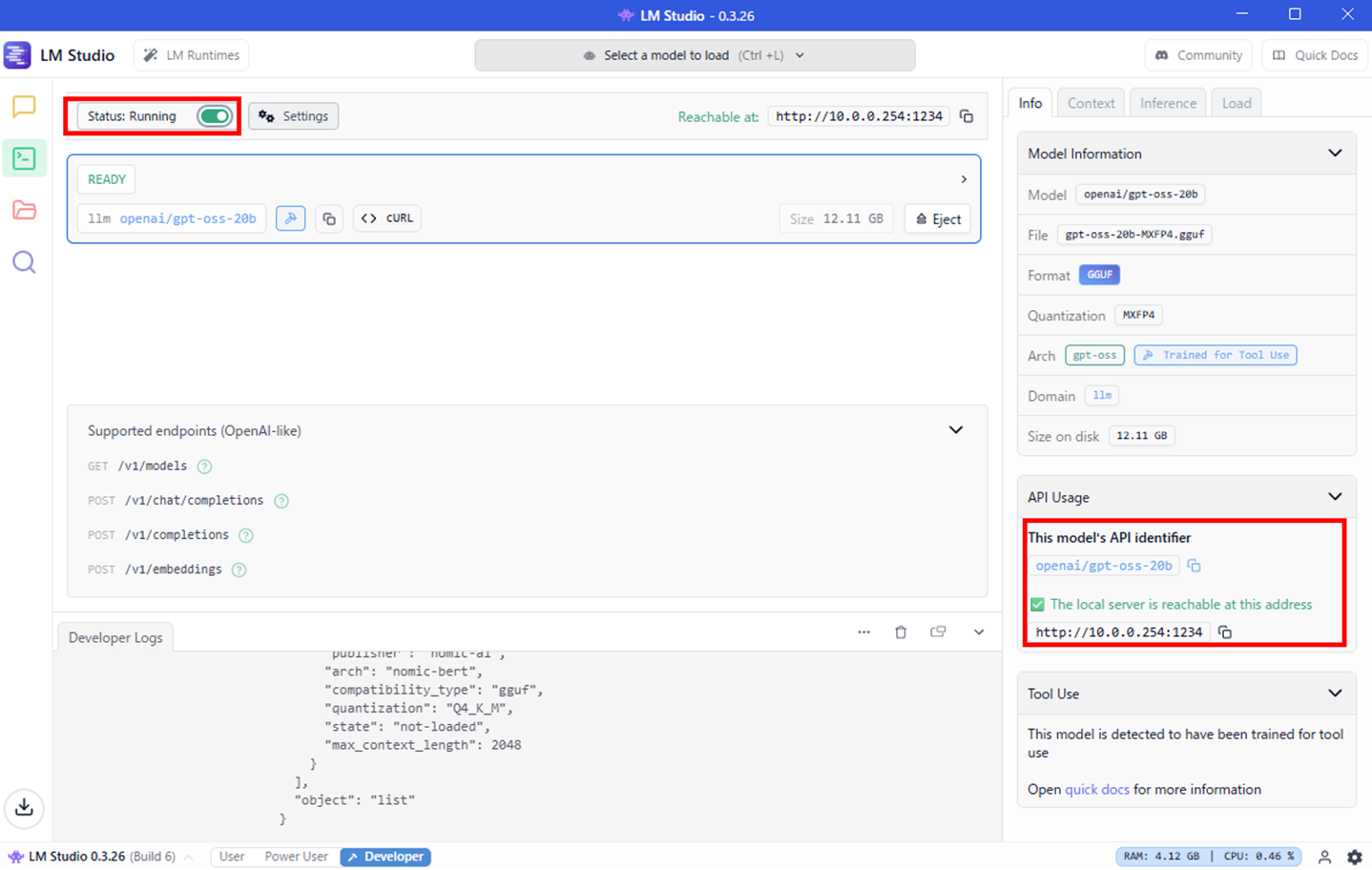

左上にある「Status」をオンに切り替え、「Running」の状態に変わったら右側のパネルの「Info」タブをクリックしましょう。「API Usage」にある情報は後でAPIへの接続に使用します。

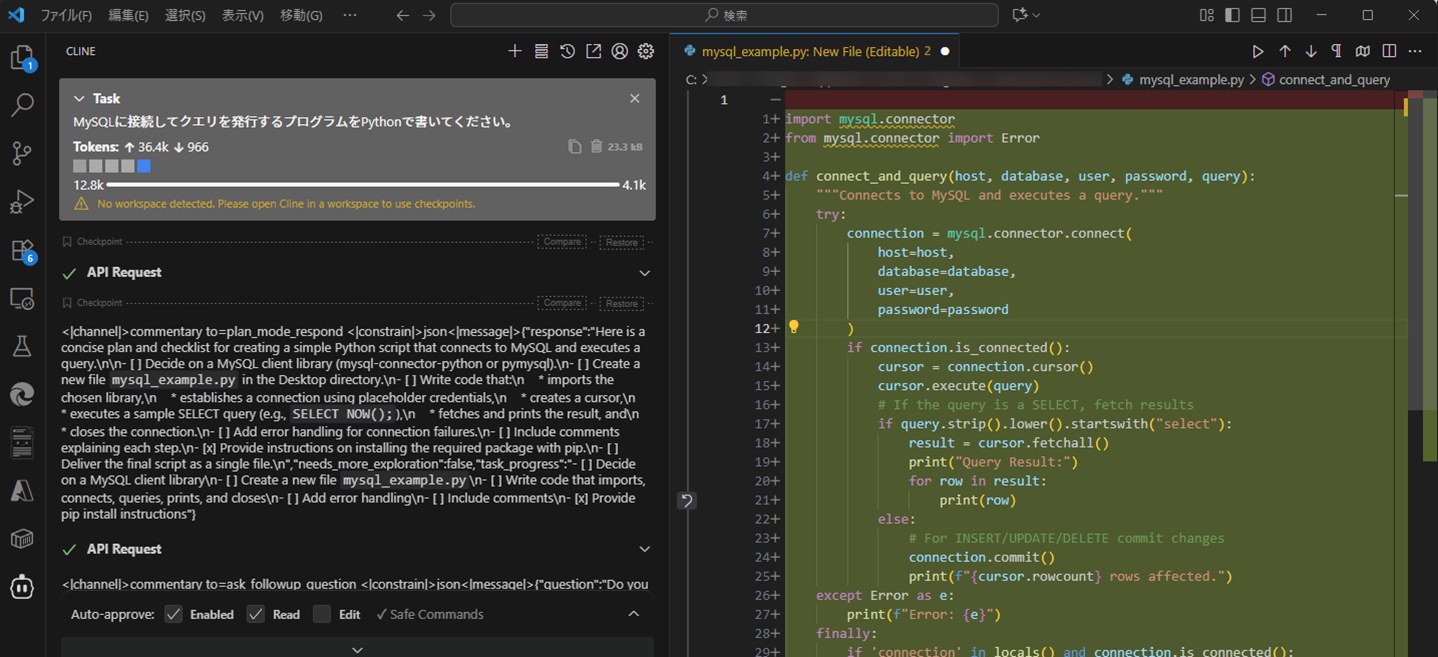

次に、Visual Studio Code(以下、VS Code)の拡張機能であるClineと連携してみましょう。Clineのインストールは以下の記事を参照してください。

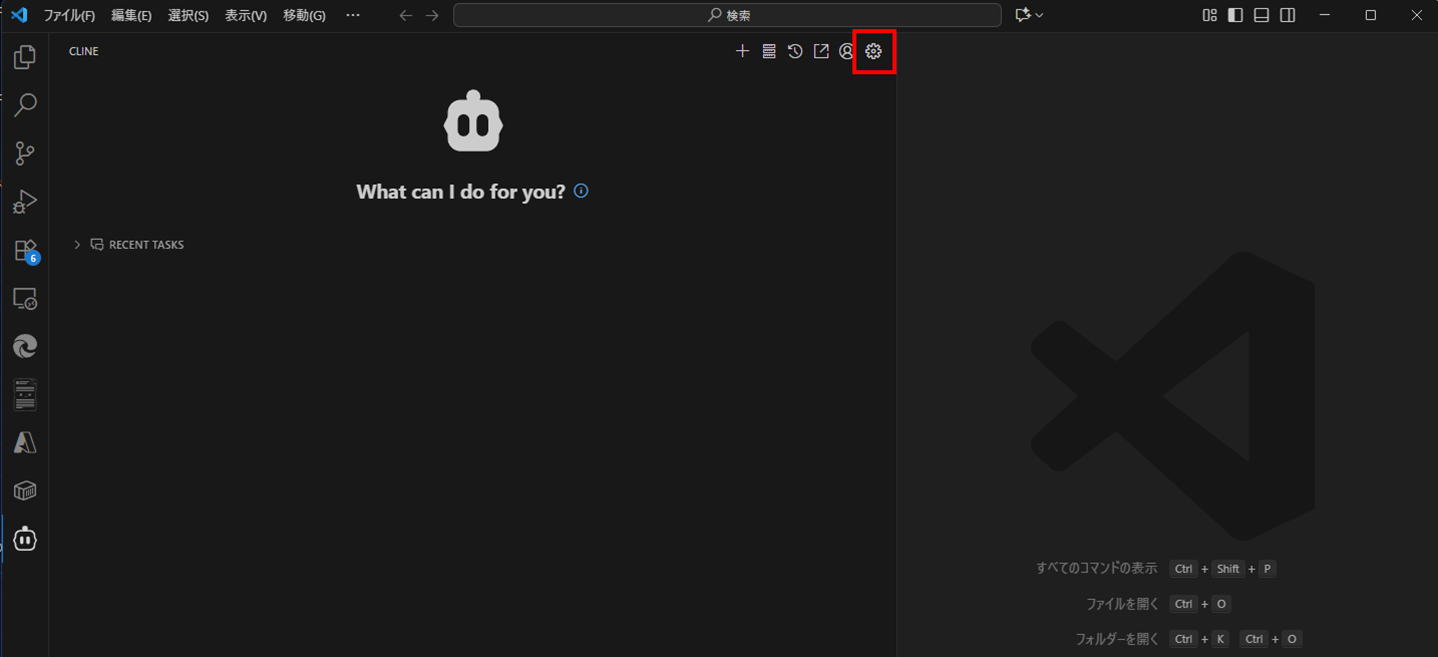

VS CodeでClineのパネルを開き、歯車アイコンを押下しましょう。

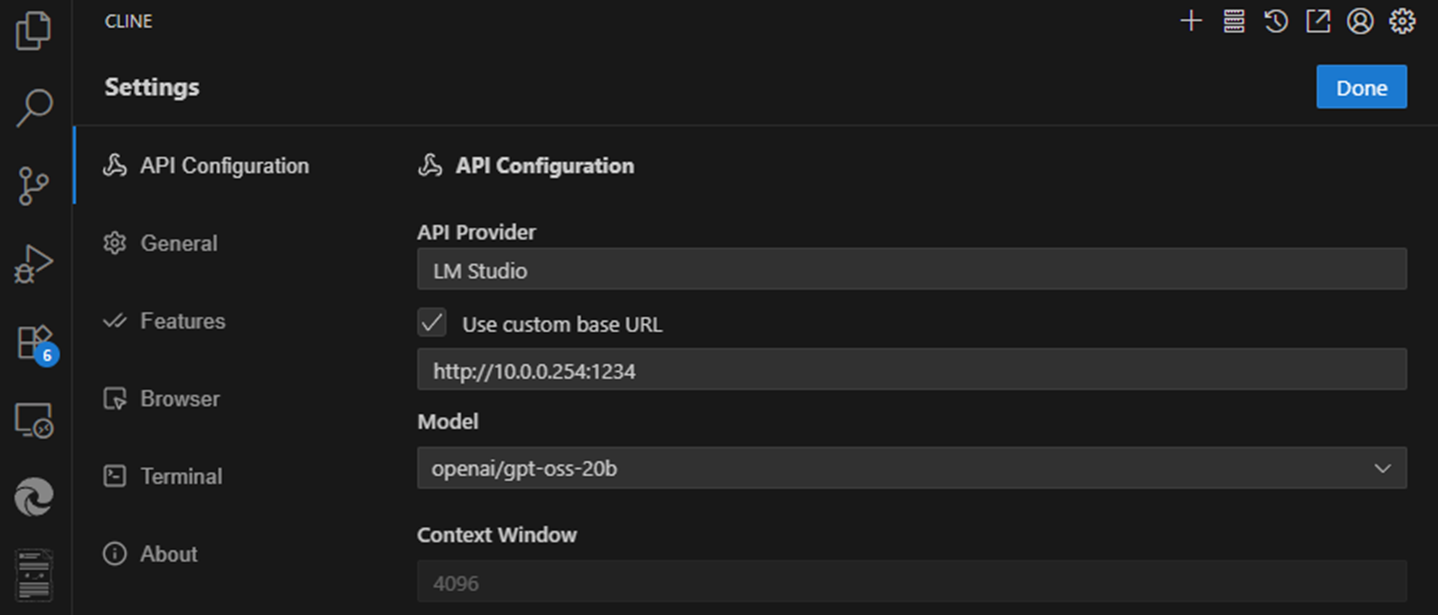

設定画面が開いたら、下記のように設定しましょう。

- API Provider:LM Studio

- Use custom base URL:LM StudioのAPI Usageに書かれた「API identifier」

- Model:LM StudioのAPI Usageに書かれたローカルサーバーアドレス

設定できたら、プロンプトを入力して動作確認してみましょう。API Requestが処理され始めれば成功です。

また、同時にLM Studioでも「Developer Logs」にログが追記されていることも確認できるでしょう。

さいごに

LM Studioは、ローカル環境で大規模言語モデルを手軽に利用できるGUIツールです。Hugging Faceなどからモデルを選んでダウンロードするだけで、オフライン利用やファイル解析、RAGによる知識拡張、API連携など多彩な機能を活用できます。クラウド型LLMのようにリクエストごとの利用料が発生しないため、大量の試行や継続利用でもコストを気にせずAI活用を進められる点も大きな魅力です。社内データを安全に扱いながら生成AIを活用したい開発者・企業にとって、導入ハードルを大幅に下げる選択肢となるでしょう。

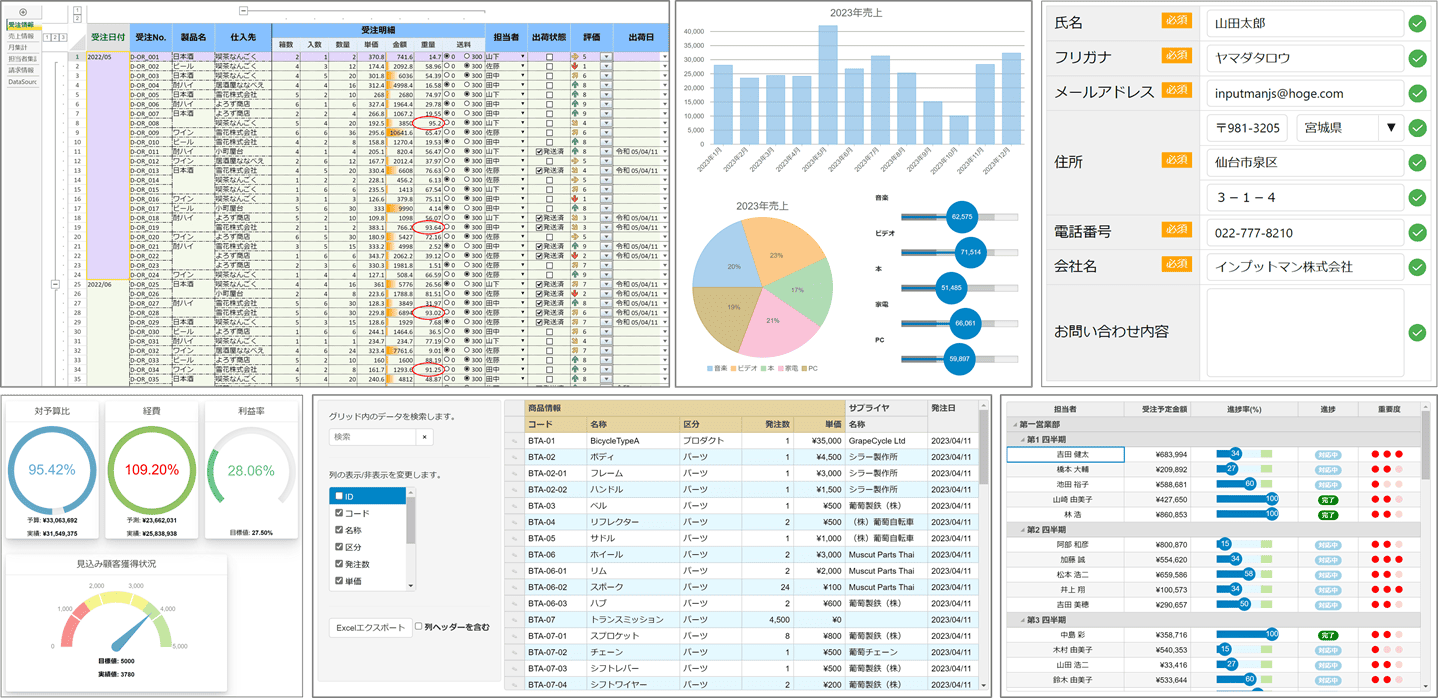

メシウスでは様々なWebアプリケーションフレームワークと一緒に使えるJavaScriptライブラリを提供しています。

無償のトライアル版や、ブラウザ上で手軽に試せるデモアプリケーションも公開しているので、こちらも是非ご覧ください。